Siri, пожалуйста, посмотрите мою часовую лекцию в университете и сделайте для меня резюме

Обобщение NLP-видео с помощью Watson и GPT

В этом проекте я исследовал возможности GPT2 (который имеет около 1 миллиарда параметров) и могу только представить себе мощь самого последнего GPT3, имеющего 175 миллиардов параметров !, который может записывать программные коды в художественные стихи. В этом проекте я использовал университетскую лекцию - Введение в статистическое обучение, подготовленную профессором Сильвией Салини (руководитель отдела науки о данных, Миланский университет), и заставил ИИ (IBM WATSON) просмотреть всю лекцию и записать ее для меня. Я обучил модель GPT 2, так что она может суммировать 500 строк текста, написанного Ватсоном, до 10 строк.

- Я использовал IBM Watson, потому что он позволяет вам бесплатно использовать 500 минут речи для преобразования текста без указания информации о кредитной карте, в отличие от Google Cloud и Azure.

- В модели GPT2 я сохранил вероятность низкой и высокий уровень использования словарного запаса, поэтому GPT2 не извлекает из себя новую информацию и не делает краткое содержание лекции совершенно неверным.

- Я только что создал прототип, обучив модель только одной лекцией, но вы можете попробовать несколько лекций по конкретному предмету для лучшего изучения модели и словарного запаса соответственно,

1 Преобразование лекции в аудиофайл

2 Заставить Уотсона смотреть лекцию и заниматься

IBM Watson имеет ограничения на количество файлов для преобразования речи в текст для бесплатных пользователей в зависимости от продолжительности и размера файла, поэтому я разделил аудиофайл лекции продолжительностью 1 час на 6 различных аудиофайлов.

Учетные данные Watson API можно получить на cloud.ibm.com и преобразовать в текстовый ресурс.

Заставляя Watson прослушивать все 6 фрагментов аудио, которые я сделал и записать в текст,

я выбрал самую первую альтернативу, которая имеет самый высокий уровень достоверности для точности.

Запись результатов в текстовый файл и объединение результатов из всех Аудио в один текстовый файл с именем lecture.txt

Настройка модели 3 GPT 2

GPT 2 - это причинно-следственная генерация текста, предварительно обученная модель из открытого ИИ, которая работает с предсказанием.

GPT-2 генерирует образцы синтетического текста в ответ на произвольный ввод модели. Модель похожа на хамелеона - она адаптируется к стилю и содержанию условного текста. Это позволяет пользователю создавать реалистичные и последовательные продолжения по теме по своему выбору - https://openai.com/blog/better-language-models/

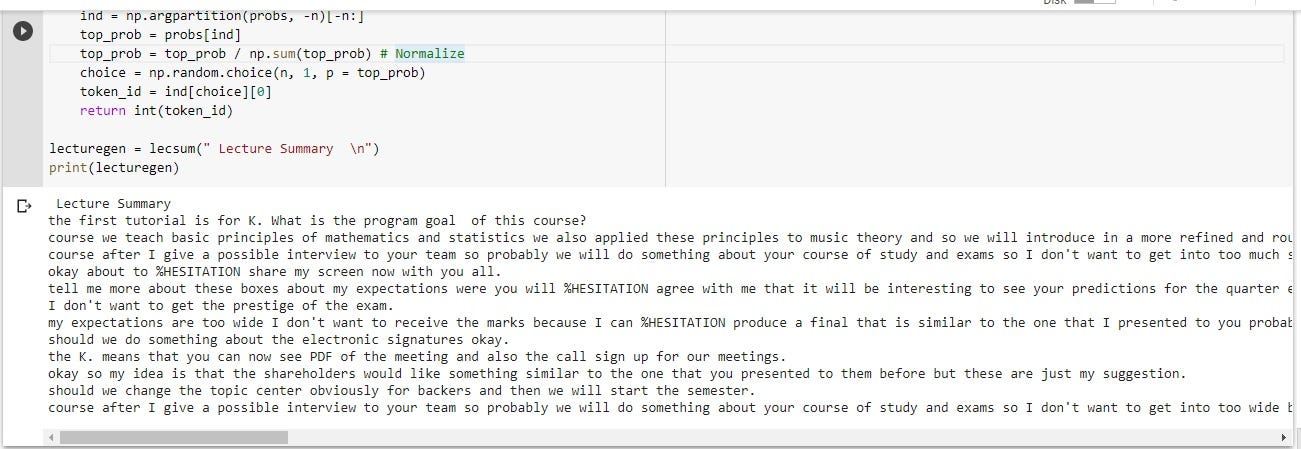

4 Резюме лекции

Результаты

Хотя мощность модели GPT2 весьма впечатляет, мы все же не можем полагаться на неопровержимые факты с GPT2, хотя я считаю, что она более точна и требует меньше времени, когда у вас меньше ресурсов для инвестирования в NLP, например, предварительно обученные модели. такие как GPT 2 или RoBERTa, очевидно, будут работать лучше, чем один человек, выполняющий встраивание слов и тренирующий модель NLP в течение недели. Итак, GPT2 хорош для начала или представления экспериментального проекта, такого как чат-боты или говорящие веб-сайты, но для более профессионального использования необходимо потратить хорошие ресурсы на индивидуальную модель НЛП в соответствии с вашими потребностями.

Для полной записной книжки и кода jupyter вы можете просмотреть мой репозиторий на github.com - https://github.com/Alexamannn/NLP-Video-Summarization-with-Watson-and-GPT