Хорошее понимание линейной алгебры является неотъемлемой частью анализа алгоритмов машинного обучения, особенно для глубокого обучения, где так много всего происходит за кулисами. Я часто замечал, что столкновение с математикой и соответствующими формулами пугает многих соискателей, и я не исключение. Но этот аспект обучения неизбежен для любого соискателя науки о данных, поэтому я попытался упростить его для себя. С намерением помочь группе начинающих соискателей я расскажу об элементарных знаниях, необходимых для понимания Deep Learning. Даю слово, что я постараюсь исключить математические формулы и выводы из этой полностью математической темы (так что экспертам это может показаться неуместным). Давайте теперь рассмотрим такие темы старшей школы, как ученик начальной школы.

Скаляры, векторы, матрицы и тензоры:

Скаляр - это просто одно число, записанное строчными буквами значками имени переменной. Вектор - это просто массив правильно проиндексированных чисел в массиве, выделенных жирным курсивом и элементами, явно представленными в столбце, заключенном в квадратные скобки, причем каждый элемент задает координаты по отдельной оси. Матрица - это двумерный массив чисел, выделенных жирным шрифтом, курсивом и прописными буквами, где каждый элемент обозначается двумя индексами. Этот массив заключен в квадратные скобки для явной матрицы, но с элементами идентификации. Тензор - это просто еще одна матрица, но с более чем двумя осями и написанная жирным шрифтом для имени переменной. Важно упомянуть Транспонирование, которое представляет собой просто зеркальное отображение матрицы вдоль главной диагональной линии (от верхнего левого угла до нижнего правого). По сути, вектор - это матрица с одним столбцом, а транспонирование вектора - это матрица с одной строкой.

Умножение матриц и векторов:

Умножение матриц обычно бывает распределительным и ассоциативным, за исключением случая матричного умножения, которое является коммутативным. M произведение матриц матриц «A» и «B» является результирующей матрицей «C», где «A» должно иметь такое же количество столбцов, как «B» имеет строки. Поэлементное произведение Адамара - это просто матрица, содержащая произведение отдельных элементов «А» и «В». И точечное произведение между двумя векторами x и y одинаковой размерности происходит между 'транспонировать x' и 'y'. Итак, если мы транспонируем матричный продукт, значение будет скалярным и равно его собственному транспонированию.

Идентичность и обратные матрицы:

Матрица идентичности, представленная как 'I', содержит все основные диагональные элементы как 1, а остальные элементы как 0. Обратная матрица помогает решить уравнение много раз для разных значений b, но не

рекомендуется использовать, поскольку его представление на цифровых компьютерах имеет ограниченную точность. Алгоритмы, использующие значение b, дают более точные оценки x.

Векторная норма:

Норма - это функция, используемая для измерения размера векторов (или даже матриц) путем сопоставления векторов с неотрицательными значениями. Мы не будем вдаваться в подробности того,

он удовлетворяет требованиям типа неравенства треугольника или нет. Простая евклидова норма - это евклидово расстояние от начала координат до точки, обозначенной как x. Иногда мы измеряем размер вектора, считая его ненулевые элементы, но это не норма, потому что масштабирование вектора не меняет количество ненулевых элементов. Другой распространенной нормой является Максимальная норма, которая упрощается до абсолютного значения элемента с наибольшей величиной в векторе,

Теперь, если мы хотим измерить размер Матрицы, мы можем использовать Норму Фробениуса, концепция которой очень похожа на концепцию евклидовой нормы,

Специальные матрицы и векторы:

›Диагональные матрицы состоят в основном из нулей и имеют ненулевые элементы только вдоль главной диагонали, как и матрица идентичности. Не все диагональные матрицы квадратные и у них нет обратных. ›Симметричные матрицы часто возникают, когда записи генерируются некоторой функцией двух аргументов, которая не зависит от порядка аргументов. ›Единичный вектор - это вектор с Единичной нормой. ›Ортонормированные векторы ортогональны и имеют единичную норму. ›Ортогональная матрица - это квадратная матрица, строки и столбцы которой взаимно ортонормированы.

Собственное разложение:

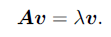

Это относится к разложению матрицы на набор собственных векторов и собственных значений для анализа различных свойств этой матрицы. Собственный вектор квадратной матрицы A - это ненулевой вектор v, такой это умножение на A изменяет только масштаб v:

Скаляр λ известен как собственное значение, соответствующее этому собственному вектору. Обратите внимание, что каждую действительную симметричную матрицу можно разложить в выражение, используя только действительные собственные векторы и собственные значения. Матрица, все собственные значения которой положительны, называется положительно определенной. Матрица, все собственные значения которой положительны или нулевые, называется положительно полуопределенной. Точно так же, если все собственные значения отрицательны, матрица отрицательно определена, а если все собственные значения отрицательные или с нулевым значением, она отрицательно полуопределенная.

SVD (Разложение по единственному значению):

Это еще один способ разложить матрицу на сингулярные векторы и сингулярные значения. SVD позволяет нам обнаруживать информацию, аналогичную разложению по собственным данным, но SVD более применима. Каждая вещественная матрица имеет SVD, но не имеет разложение по собственным значениям. Например, если матрица не квадратная, собственное разложение не определено, тогда нам потребуется SVD. Самая полезная особенность SVD заключается в том, что мы можем использовать его для частичного обобщения инверсии матриц на неквадратные матрицы.

Псевдообратная модель Мура-Пенроуза:

Инверсия матриц не определена для матриц, которые не являются квадратными, и именно здесь Псевдообратная матрица Мура-Пенроуза позволяет нам добиться некоторого прогресса.

Здесь U, D и V - разложение A по сингулярным числам, а псевдообратное D + диагональной матрицы D получается обратной величиной ее ненулевых элементов, а затем транспонированием полученной матрицы.

Оператор трассировки:

Он дает сумму всех диагональных элементов матрицы. Некоторые операции, которые сложно указать без использования нотации суммирования, можно указать с помощью матричных произведений и оператора трассировки.

Написание выражения в терминах оператора трассировки позволяет манипулировать выражением, используя различные полезные идентификаторы. Обратите внимание, что скаляр - это отдельный след: a = Tr (a).

Определитель: Определитель квадратной матрицы, обозначаемый det (A), представляет собой функцию, которая отображает матрицы в действительные скаляры. Определитель равен произведению всех собственных значений матрицы. Абсолютное значение определителя можно рассматривать как меру того, насколько умножение на матрицу расширяет или сжимает пространство. Если определитель равен 0, то пространство полностью сжимается по крайней мере по одному измерению, в результате чего оно теряет весь свой объем. Если определитель равен 1, то преобразование сохраняет объем.

Сейчас я завершу этот обзор основ линейной алгебры, необходимого для продвижения в области науки о данных и машинного обучения. Это, конечно, не все, что нам нужно знать, но это определенно может служить отправной точкой. Если мы сразу не призываем стать единорогом в области науки о данных, этого должно быть достаточно для начала. Пожалуйста, держите меня в курсе, если вы обнаружите какие-либо несоответствия в этом сообщении. Удачи и ниже - несколько других ресурсов, которые вы хотели бы изучить по другим актуальным темам: