В свете недавнего прогресса в области ИИ практически невозможно не услышать или не прочитать о различных вехах или новых продуктах, использующих ИИ. Беллоу делает попытку объяснить различные термины и понятия и то, как они связаны друг с другом.

Машинное обучение часто является основой для систем искусственного интеллекта, представляющих собой алгоритмы, используемые для построения модели на основе данных выборки/обучения, чтобы делать прогнозы или принимать решения без явного программирования для этого.

Глубокое обучение – это подмножество машинного обучения, преимущество которого состоит в том, что оно устраняет некоторые трудности, связанные с извлечением признаков (уменьшая количество ресурсов, необходимых для описания большого набора данных). . Глубокое обучение основано на искусственных нейронных сетях, а процесс обучения является глубоким, поскольку структура искусственных нейронных сетей состоит из множества входных, выходных и скрытых слоев.

Модели машинного обучения можно классифицировать… на основе:

Тип обучения

- Контролируемый: основанный на размеченных данных, обучение на прошлых примерах для прогнозирования будущих значений, например. классификация, регрессия.

- Неконтролируемое: просматривает необработанные данные (немаркированные данные) и проверяет, попадают ли данные в группы, например. кластеризация.

- Поощрение:модель обучается посредством максимизации вознаграждения. обратная связь.

Тип прогноза

- Дискриминативный: обучение на наборе размеченных данных, обычно используемом для классификации или прогнозирования меток.

- Генеративный: понимает распределение данных и создает новые данные, похожие на данные, на которых он обучался.

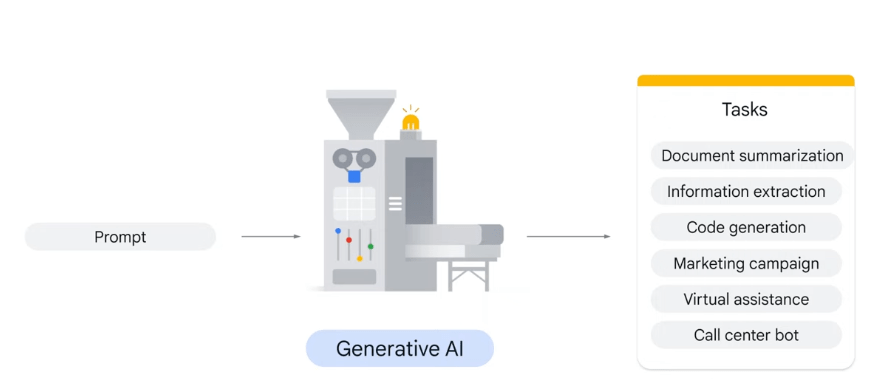

Генеративный ИИ — это более широкое понятие, охватывающее различные методы создания систем ИИ, способных создавать различный контент (текст, изображения, аудио и синтетические данные). Модель учится на существующем контенте (посредством обучения) и создает статистическую модель, которая используется для прогнозирования того, каким может быть результат/ответ, по сути, она генерирует новый контент. Сила генеративного ИИ заключается в использовании архитектуры трансформеров в сочетании с основополагающими моделями.

Фундаментальная модель — это большая модель, предварительно обученная на огромном количестве данных, предназначенная для адаптации (или тонкой настройки) для широкого круга последующих задач, таких как анализ тональности, подписи к изображениям и распознавание объектов. Базовая модель — это любая модель, обученная на обширных данных (как правило, с использованием самоконтроля в масштабе), которую можно адаптировать (например, точно настроить) к широкому кругу последующих задач; текущие примеры включают BERT [Devlin et al. 2019], GPT-3 [Brown et al. 2020] и CLIP [Radford et al. 2021].

Внимание — это все, что вам нужно: кодер-декодер + механизм самоконтроля

Архитектура преобразователя приобрела значительную популярность, особенно в области НЛП, после выхода статьи Внимание — это все, что вам нужно.

Традиционно архитектура кодер-декодер основана на механизме Seq2Seq (последовательность к последовательности), но секретным соусом является усовершенствование архитектуры Seq2Seq за счет использования механизма внимания. , который устраняет ограничения классического Seq2Seq при работе с длинными последовательностями.

Техника внимания позволяет нейронной сети сосредоточиться на определенных частях входной последовательности, вычисляя весовые коэффициенты внимания (назначаемыеразличным частям входной последовательности). последовательность, наиболее важным частям которой присваивается наибольший вес) и создание вектора контекста.

Модель преобразователя — это модель глубокого обучения, которая использует самовнимание для изучения взаимосвязей между различными частями последовательности. Принципиально модели внимания отличаются от традиционной модели передачей декодеру большего количества информации.

Большие языковые модели

LLM — это разновидность глубокого обучения, они предварительно обучаются, а затем настраиваются для конкретных целей. Наборы данных для LLM имеют порядок петабайт и имеют большое количество параметров (гиперпараметров), например. ~540 миллиардов параметров.

В основе LLM лежит архитектура кодировщик-декодер, которая принимает последовательность слов в качестве входных данных и выводит последовательность слов. Кодировщик преобразует входную последовательность в векторное представление, а декодер генерирует выходную последовательность. strong> из векторного представления и, что не менее важно, предсказывает следующее слово в выходной последовательности. Есть два способа генерировать текст из обученной модели кодировщик-декодер во время обслуживания:

- Жадный поиск — всегда выбирает слово с наибольшей вероятностью

- Лучевой поиск — несколько возможных слов и выбирает слово с наибольшей комбинированной вероятностью.

Подсказка и оперативный дизайн

Ввод пользователя, обычно исходный текст, состоящий из нескольких слов или предложений, на самом деле называется подсказкой. Он отправляется в модель, чтобы инициировать процесс генерации языка.

Интересно то, что подсказка может быть вопросом или предложением. В случае, когда подсказка является вопросом, ответом будет ответ на вопрос, а если подсказка является утверждением, ответ может быть продолжением заявление или родственное заявление.

Когда модель получает подсказку, она разбивает ее на токены (с точки зрения высокого уровня токенизация — это процесс разбиения предложения на слова) и использует свой механизм внимания для обработки токенов один за другим.

LLM создает массив вероятностей слов, которые могут быть следующими. Увеличение случайности дает общее ощущение творческих ответов.

При подсказке часто бывает полезно попросить классифицировать, а не генерировать, и добавить примеры или инструкции:

- Zero-shot: одна команда LLM без примера

- одноразовый: предоставить один пример для LLM

- несколько выстрелов: несколько примеров

На результат модели влияют ее параметры (температура, top P и top K), которые регулируют случайность ответ, контролируя выбранные выходные токены.

Температура регулирует степень случайности при выборе токенов, низкая температура выбирает слова с высокой вероятностью и дает более «предсказуемые» ответы, тогда как высокая температура выбирает слова с низкой вероятностью и дает общий результат. ощущение творческих ответов. Температура 0 делает модель детерминированной.

Top K (число) изменяет то, как модель выбирает токены для вывода. Верхний k, равный 1, означает, что выбранный токен является наиболее вероятным среди всех токенов в словаре модели (это также называется жадным декодированием), а верхний k, равный 3, означает, что следующий токен выбирается из 3 наиболее вероятных токенов ( с помощью температуры).

Top P (вероятность) изменяет то, как модель выбирает токены для вывода. Жетоны выбираются от наиболее вероятного к наименее до тех пор, пока сумма их вероятностей не будет равна значению top-p, т. е. если токены A, B и C имеют вероятность 0,3, 0,2 и 0,1, а значение top-p равно .5, то модель выберет либо A, либо B в качестве следующего маркера (используя температуру).

Случайность очень легко вводит нас в заблуждение, и она может представить данные как не имеющие различимой закономерности, поэтому очень важно проводить различие между двумя разными областями статистики:

- Описательный: обобщить наблюдения

- Вывод: рабочие оценки/прогнозы, основанные на наблюдениях.

Разделите данные на наборы обучения и проверки. Разделение данных на два набора позволяет обучить модель с помощью обучающего набора, а затем протестировать модель на невидимых данных из тестового набора. . Когда вы тестируете модель с невидимыми данными из тестового набора, вы можете сравнить предсказанную точность модели.

Чтобы определить подходящий алгоритм, важно задать ряд вопросов относительно желаемого результата:

- Это А или Б? → Алгоритмы классификации (двухклассовая или многоклассовая классификация)

- Это странно или не нормально? → Алгоритмы обнаружения аномалий

- Сколько или сколько? → Алгоритмы регрессии (непрерывные данные)

- Как это организовано? → Алгоритмы кластеризации (Каким зрителям нравятся фильмы одного типа?)

- Что мне теперь делать? → Алгоритмы обучения с подкреплением (процесс принятия решений и система вознаграждений, например: автономное вождение)

В конечном счете, новые технологии, как правило, следуют сигмовидной кривой прогресса, S-образной кривой, которая описывает медленный взлет технологии, за которым следует рост по мере того, как скорость внедрения увеличивается, и технология становится все лучше и лучше, и когда предел того, что возможного с этой технологией, скорость прогресса снова выравнивается. Только время покажет, верно ли это для генеративного ИИ.