Первый уровень древовидного подхода. Это также дерево классификации и регрессии (CART).

Давайте начнем с мысленного эксперимента, чтобы немного мотивировать, почему мы будем использовать метод дерева решений.

Представьте себе сценарий, что я играю в теннис каждую субботу и всегда приглашаю друга пойти со мной. Иногда появляется мой друг, иногда нет. Для него это зависит от множества факторов, таких как: погода, температура, влажность, ветер и т. д. Я начинаю следить за новыми функциями и за тем, появился ли он, чтобы поиграть со мной.

Вот данные, каждый из столбцов представляет функции, а каждая из строк представляет определенный день. В последнем столбце указано, пришел ли мой друг поиграть со мной. Вы можете видеть, что в первый день была умеренная температура, солнечная погода, влажность 80%, без ветра, и мой друг вышел поиграть.

Однако на 2-й день было жарко, погода солнечная, влажность 75%, дул ветер, и мой друг не пришел играть. С помощью этого процесса я могу построить дерево решений, которое помогает предсказать, появится ли он в игре, с учетом нескольких факторов. Интуитивный способ сделать это — использовать дерево решений.

Как правило, у нас есть терминология в Дереве решений. В приведенном выше дереве мы имеем

→ Корневой узел: узел, выполняющий первое разделение.

→ Узлы решений:промежуточные узлы, которые разделяются по значению определенных атрибутов.

→ Листья:конечные узлы, которые предсказывают результат.

Вы можете подумать, как происходят эти расщепления? Вот где прирост информации (энтропия) или индекс Джини играет важную роль в разделении узлов. Это математические методы выбора наилучшего разделения.

Во-первых, позвольте мне рассказать об Энтропии, чтобы понять прирост информации.

Энтропия – это мера неопределенности или примеси. Он измеряет чистоту раскола. На приведенном ниже рисунке мы можем понять, что низкая энтропия означает низкое смешивание переменных, тогда как высокая энтропия означает сильное смешивание переменных.

Существует два шага для расчета прироста информации для каждого атрибута:

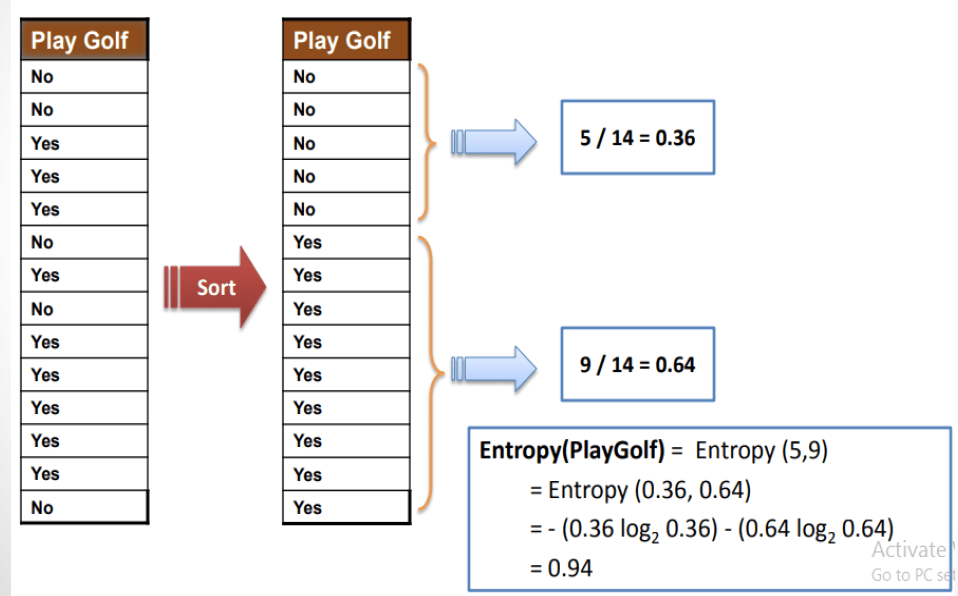

→ Рассчитать энтропию цели.

→ Рассчитайте энтропию каждого атрибута.

Чтобы проиллюстрировать, как работает получение информации, позвольте мне взять в качестве примера приведенный выше набор данных. Сначала нам нужно рассчитать энтропию мишени, и она рассчитывается следующим образом.

Затем нам нужно рассчитать энтропию атрибутов. Чтобы вычислить энтропию атрибутов, нам нужно создать таблицу частот для атрибутов.

Затем вычислите энтропию каждого атрибута.

Точно так же информационный прирост рассчитывается для каждого атрибута.

Из приведенного выше расчетного изображения прироста информации мы можем прийти к выводу, что функция Outlook имеет высокое значение I.G, что означает, что она имеет высокую чистоту меток или меньшее количество целевых меток, так что мы можем создать корневой узел дерева с Outlook.

Давайте повторим тот же процесс, за исключением Outlook.

Из приведенной выше таблицы мы можем сказать, что нет смеси меток, если сценарий пасмурный, человек приходит играть, поэтому мы можем сразу построить узел решения с этим.

На следующем шаге мы можем рассчитать прирост информации для функции прогноза «солнечный».

Исходя из приведенного выше расчета, функция Windy имеет самое высокое значение IG, поэтому мы можем построить дерево решений с этой переменной.

Далее нам нужно найти узел решения, если прогноз ненастный.

Влажность имеет самое высокое значение информационного усиления. Функция влажности используется в качестве узла принятия решения для следующего построения дерева.

Глядя на окончательную структуру дерева решений, мы можем легко предсказать окончательный результат различных сценариев.

Индекс Джини используется как метод по умолчанию для построения дерева решений.

Шаги для построения дерева с использованием метода Индекса Джини такие же, как и для энтропии. Поскольку мы берем сумму квадратов вероятности для каждой категории класса, а не логарифмическое значение, скорость вычислений выше, чем у метода энтропии.

Для непрерывных значений наилучшее разделение рассчитывается методом Уменьшение стандартного отклонения (SDR).

Это то же самое, что и энтропийный подход, тогда как стандартное отклонение значений рассчитывается вместо энтропии.

Преимущества:

- Дерево решений очень легко реализовать и легко понять.

- Деревья могут легко обрабатывать и инициировать предсказания.

Недостатки:

- Деревья обычно не имеют такого же уровня точности прогнозирования, как любой другой подход регрессии и классификации.

- Это часто приводит к переоснащению, что означает, что дерево дает хороший результат для обучающих данных и плохие результаты для тестовых данных.

Вывод:

- Дерево решений — это очень старая концепция и основа для модернизированных моделей, таких как случайный лес, методы бустинга. Чтобы понять все эти алгоритмы, нам нужно понять метод работы дерева решений.

- Надеюсь, вы получили общее представление о том, как работает дерево решений. Спасибо за прочтение статьи.

- Обратитесь к этой ссылке для реализации дерева решений в Python.