По мере того как машинное обучение (ML) становится все более эффективным и широко распространенным, оно становится все более распространенным в системах, оказывающих реальное влияние, от рекомендаций по кредитам до решений о приеме на работу. С ростом использования возникает риск предвзятости - предвзятые данные обучения могут привести к предвзятым алгоритмам машинного обучения, что, в свою очередь, может увековечить дискриминацию и предвзятость в обществе.

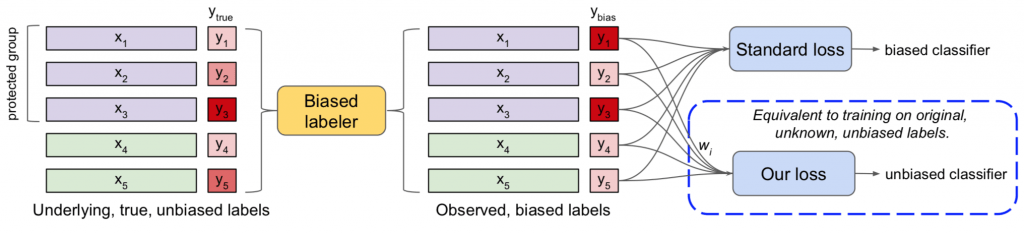

В новой статье от Google исследователи предлагают новую технику для беспристрастного обучения алгоритмов машинного обучения даже с использованием предвзятого набора данных. В основе этой техники лежит идея о том, что предвзятый набор данных можно воспринимать как беспристрастный набор данных, который подвергся манипуляциям со стороны предвзятого агента. Используя эту структуру, смещенный набор данных повторно взвешивается, чтобы соответствовать (теоретическому) несмещенному набору данных, и только затем вводится в алгоритм машинного обучения в качестве обучающих данных. Этот метод позволяет получить самые современные результаты в нескольких общих тестах на честность, при этом обеспечивая относительно низкую частоту ошибок.

Фон

Пытаясь оценить систематическую ошибку в алгоритмах, исследователи обычно обращают внимание на четыре ключевых показателя:

- Демографический паритет. Классификатор должен делать положительные прогнозы для защищенной группы населения с той же скоростью, что и для всего населения.

- Несопоставимое воздействие - аналогично демографическому паритету, но классификатор не знает, какие защищенные группы населения существуют и какие точки данных относятся к таким защищенным группам.

- Равные возможности - классификатор должен иметь одинаковые истинно положительные коэффициенты для защищенной группы населения и для всего населения.

- Выравниваемые шансы - классификатор должен иметь одинаковые значения истинно положительных и ложноположительных для защищенной группы населения и для всего населения.

Каждая высокоуровневая метрика выражается в виде неотрицательного числа, которое описывает, насколько близок классификатор к полной справедливости, при этом оценка 0 означает отсутствие предвзятости.

В последние годы исследователи предложили несколько подходов к снижению систематической ошибки в алгоритмах. Их можно разделить на три ключевые категории: предварительная обработка данных, постобработка данных и расширение алгоритмов (лагранжев подход).

Предварительная обработка данных

При предварительной обработке исследователи пытаются уменьшить систематическую ошибку, манипулируя обучающими данными перед обучением алгоритма. Предварительная обработка концептуально проста и поэтому потенциально привлекательна, но страдает двумя ключевыми проблемами:

- Технические - данные могут быть смещены сложным образом, что затрудняет преобразование алгоритма в новый набор данных, который является одновременно точным и беспристрастным.

- Юридические - В некоторых случаях нельзя обучать алгоритм принятия решения на необработанных данных.

Постобработка данных

При постобработке исследователи пытаются уменьшить систематическую ошибку, манипулируя обучающими данными после обучения алгоритма. Как и в случае с предварительной обработкой, ключевой задачей при постобработке является поиск методов, которые точно распознают смещение, что позволяет им уменьшить смещение и поддерживать точность алгоритма.

Увеличение алгоритма (лагранжев подход)

Недавний подход состоит в том, чтобы включить справедливость в сам алгоритм обучения, наказывая влияние предвзятых выборок. Это делается с помощью математического метода, называемого множителями Лагранжа, который принимает ограничения справедливости (например, пожилых людей следует принимать с той же скоростью, что и молодые люди) в качестве входных данных и использует их, чтобы влиять на потери в алгоритме обучения. . Лагранжев подход в настоящее время является наиболее популярным, но его часто сложно реализовать и он значительно усложняет процесс обучения.

Рамки коррекции смещения

Как описано ранее, в предлагаемой структуре мы предполагаем, что смещенный набор данных (y_bias) является результатом манипулирования (теоретическим) несмещенным набором данных y_true. Это можно представить как:

Первым этапом метода является изучение значений λk, которые представляют связь между несмещенным набором данных y_true и смещенным набором данных y_bias. Выученные значения λk используются для вычисления веса wk каждой обучающей выборки, при этом смещенные выборки получают низкие веса, а несмещенные выборки - большие веса. Затем алгоритм ML получает в качестве входных данных как точки данных, так и веса, и использует их для обучения несмещенного классификатора.

Как описано в документе, обучение λk работает следующим образом: «идея состоит в том, что если скорость положительного предсказания для защищенного класса G ниже, чем общая скорость положительного предсказания, то соответствующий коэффициент должен быть увеличен; то есть, если мы увеличим веса положительно помеченных примеров G и уменьшим веса отрицательно помеченных примеров G, то это будет стимулировать классификатор к повышению своей точности на положительно помеченных примерах в G, в то время как точность на отрицательно помеченных примерах в G помеченные примеры G могут упасть ».

На практике наш процесс состоит из двух частей - процесса обучения коэффициентов и окончательного обучения модели машинного обучения на основе объективных данных. Важно отметить, что, хотя в процессе обучения ограничениям используется классификатор для определения коэффициентов смещения λk, нет необходимости использовать тот же классификатор при построении модели машинного обучения.

На практике наш процесс состоит из двух частей - процесса обучения коэффициентов и окончательного обучения модели машинного обучения на основе объективных данных. Важно отметить, что хотя в процессе обучения ограничениям используется классификатор для определения коэффициентов смещения λk, нет необходимости использовать тот же классификатор при построении модели машинного обучения.

Процесс обучения коэффициентам состоит из четырех отдельных этапов:

- Оцените демографические ограничения, предоставив функцию потерь при нарушении ограничений.

- Обновите коэффициенты λk в соответствии с нарушениями ограничений, что означает попытку минимизировать функцию потерь.

- Вычислите веса wk для каждой обучающей выборки.

- Переобучите классификатор с обновленными весами.

Эти этапы повторяются до тех пор, пока ограничения не перестанут нарушаться, а это означает, что в наборе данных больше не будет смещения. На этом этапе вычисленные веса можно использовать на этапе построения модели, при этом каждая обучающая выборка получает другой вес в зависимости от ожидаемого смещения.

Полученные результаты

Предлагаемый метод был протестирован с использованием логистической регрессии в пяти распространенных схемах предвзятости ОД - Банковский маркетинг (ответ на кампанию прямого маркетинга), Сообщества и преступность (уровень преступности в различных сообществах), КОМПАС (рецидивизм), Кредитные данные в Германии (кредитный риск физических лиц) и для взрослых (прогноз дохода). Результаты сравнивались с ведущими подходами предварительной обработки («Unc.»), Постобработки («Cal.») И Лагранжа («Lagr.») По четырем общим показателям смещения - демографическому паритету («Dem. Par.») ), Несоразмерное влияние («Дисп. Влияние»), Равные возможности («Уравн. Противобор.») И Уравненные шансы («Уравн. Шансы»). В большинстве случаев предложенная методика («Наша…») давала наилучшие результаты при небольшом снижении точности. Никакая другая техника не была столь же точной и беспристрастной.

Исследователи также протестировали технику на MNIST, создав смещение метки, случайным образом выбрав 20% точек обучающих данных и изменив их метку на 2. Затем они отправили данные в алгоритм с ограничением «каждое число должно появиться на 10%». время », и сравнил результаты с методами предварительной обработки, постобработки и Лагранжа. В результате снова был получен наивысший балл за предложенную технику несмещения («Наш метод»):

Детали реализации

Этот метод представляет собой общую основу для коррекции смещения и поэтому не зависит от какой-либо программной платформы или реализации. Естественно, добавление фазы определения веса продлит любой тренировочный процесс, в котором она используется.

Заключение

В своей структуре коррекции смещения Цзян и Нахум предлагают, чтобы за набором смещенных данных можно было предположить наличие скрытого несмещенного набора данных, и показывают, что повторное взвешивание смещенного набора данных соответствующим образом может достичь лучших результатов среди нескольких методов снижения смещения. Ожидается, что методы уменьшения смещения будут становиться все более важными по мере того, как все больше алгоритмов машинного обучения затрагивают нашу повседневную жизнь, и похоже, что метод Цзян и Нахум теперь является новым эталоном для таких методов.