Недавно я нашел исследовательскую работу, которая повысила эффективность модели за счет использования функции активации ELU вместо функции ReLU. В этом блоге я буду исследовать новую функцию ELU. Я также сделал записную книжку на Kaggle, чтобы продемонстрировать работу функции ELU с помощью кода и интерактивного сюжета.

Функция ReLU

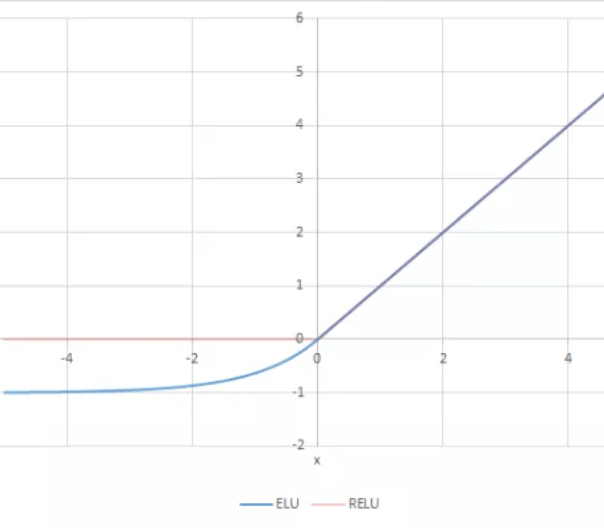

Прежде чем объяснять ELU, мы начнем с объяснения функции ReLU. Функция активации возвращает все числа и преобразует отрицательные веса в ноль. Функция ReLU была предназначена для уменьшения сложности модели и добавления нелинейности в сеть. Ниже приведено графическое представление функции. Некоторые нейроны могут содержать важную информацию; однако из-за функции ReLU их веса могут не обновляться. Другими словами, ReLu может привести к неактивным нейронам. Ниже приведено графическое представление функции.

Функция ЭЛУ

В отличие от ReLU, функция ELU медленно сглаживается до постоянного значения. Одним из преимуществ функции ELU является то, что она может передавать отрицательные значения, в отличие от функции ReLU, при этом снижая сложность. Одним из недостатков является то, что она медленнее, чем функция ReLU в обучении. Это может быть незаметно в небольших сетях, но время увеличивается по мере того, как сети становятся больше. Ниже приведено графическое представление сети ELU.

Заключение

Хотя было много разговоров об эффективности ReLU и его альтернатив, я нашел функцию ELU довольно привлекательной, поскольку она может решить умирающую проблему ReLU и добавить нелинейность в сеть.

Библиография

Вот исследовательская работа, в которой я нашел потенциальное использование ELU.

Юнг, Х.-К.; Чой, Г.-С. Улучшенный YOLOv5: эффективное обнаружение объектов с использованием изображений дронов в различных условиях. заявл. науч. 2022, 12, 7255. https://doi.org/10.3390/app12147255